Po nedavnih poročilih naj bi napaka v sistemu povzročila nenamerno razkritje zasebnih uporabniških pogovorov, ki so se znašli na kraju, ki je tako nepričakovan kot zaskrbljujoč: v Google Search Console (GSC). Incident odpira nova, resna vprašanja o varnosti podatkov, ki jih zaupamo umetni inteligenci.

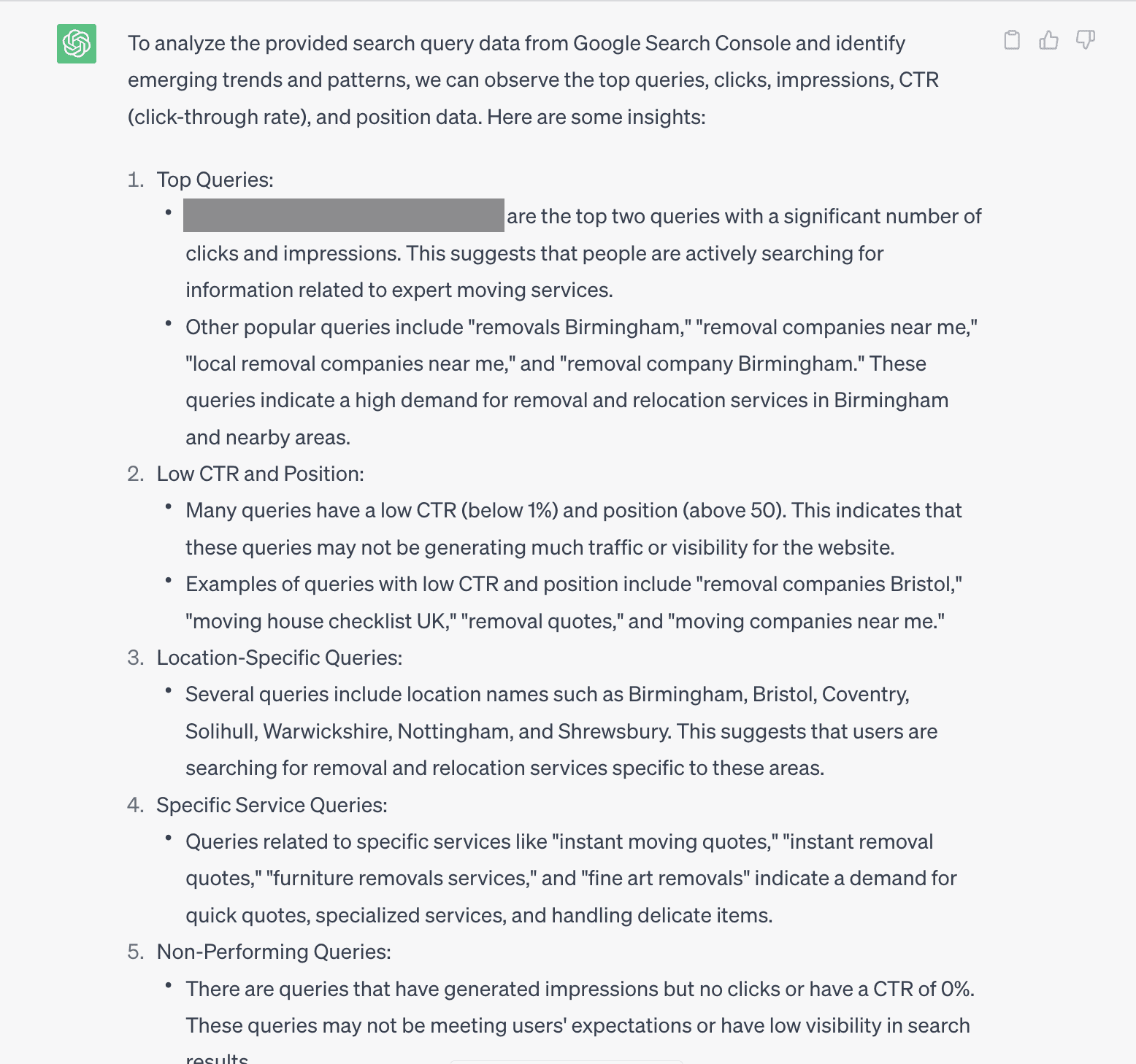

Gre za morda enega najbolj nenavadnih primerov doslej: kaže, da so zasebna vprašanja in pozivi, poslani ChatGPT-ju, postali vidni znotraj sistema Google Search Console platforme, ki jo razvijalci in spletni strokovnjaki uporabljajo za spremljanje iskalnega prometa in učinkovitosti svojih spletnih mest v iskalnikih. To vsekakor ni okolje, kjer bi pričakovali pojav osebnih in potencialno občutljivih pogovorov.

Po poročanju Ars Technice je OpenAI obstoj težave potrdil in jo pripisal “glitchu“. Podjetje je navedlo, da je bila anomalija odpravljena in da je prizadela le “majhno število iskalnih poizvedb“. Kljub temu je narava napake vzbudila precejšnje skrbi. Tudi omejena izpostavljenost je v tehničnem orodju dejansko razkrila informacije, za katere so uporabniki menili, da so zaupne.

Kako so te klepetalne seje končale v GSC?

Čeprav OpenAI uradno ni potrdil niti zanikal teorije, je verjetno razlago ponudil Jason Packer, lastnik svetovalnega podjetja Quantable, ki je med prvimi opozoril na težavo oktobra. Packer domneva, da bi incident lahko bil povezan s prakso “scrapinga” na strani OpenAI.

Poenostavljeno: da bi ChatGPT odgovoril na uporabniško vprašanje, bi lahko poizvedoval po Googlu, pri tem pa bi te poizvedbe nehote “odseval” v Googlov nadzorni sistem.

Spletno strganje (scraping) je postalo pogosta bližnjica številnih AI podjetij za hitro iskanje odgovorov. A gre za pravno in etično sivo območje. Več podjetij se je že znašlo v težavah zaradi nelegalnega strganja spletnih mest, ki to izrecno prepovedujejo. Čeprav OpenAI trdi, da je hrošč odpravljen, Packer ostaja skeptičen, zlasti če se ne naslovi morebitni glavni vzrok – strganje Googla.

AI klepetalniki niso zasebni

Ta epizoda ni osamljen primer za OpenAI in poudarja neprijetno resnico: spletni AI klepetalniki niso zasebni. Incident se pridružuje rastočemu seznamu skrbi glede zasebnosti, ki obkrožajo te tehnologije, vključno s sodnimi primeri, kjer je bila zahtevana celotna zgodovina klepetov.

Mnogi uporabniki se na ChatGPT in druge klepetalnike zanašajo ne le pri delu, temveč tudi kot zamenjavo za prijatelje ali celo terapevte, pri čemer delijo zelo osebne informacije. Čeprav je OpenAI poskušal takšne rabe omejiti (še posebej po tožbi staršev umrlega najstnika) se težave še naprej pojavljajo.

To uhajanje (leak) je trd opomnik na vedno prisotna tveganja, ki spremljajo AI klepetalnike. Uporaba spletne storitve umetne inteligence pomeni, da dejansko odstopiš del nadzora nad svojimi podatki. Nobenega trdnega zagotovila ni, kje lahko te informacije na koncu pristanejo.

Kdor namerava redno uporabljati ChatGPT ali kateri koli drug AI klepetalnik, naj bo skrajno previden glede tega, kar deli. Tisto, kar imamo za zasebni pogovor, se lahko nekega dne znajde na mestu, kjer nikakor ne bi smelo biti.